FACEBOOK ES LA RED QUE CONCENTRA MÁS MATERIAL

Es la primera vez que los reportes de las

empresas tecnológicas a las autoridades muestran más videos de contenido pornográfico que fotos. Facebook

es la red donde se concentra más material, sobre todo en su aplicación Messenger.

El Centro Nacional para Menores Desaparecidos y

Explotados un centro de información para imágenes de abuso designado de manera

federal.

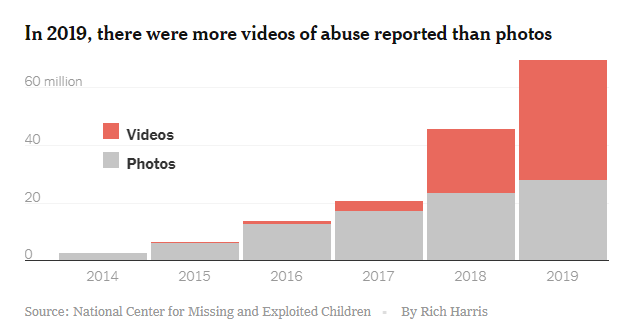

El número reportado de

fotografías, videos y otros materiales relacionados con el abuso sexual

infantil en línea creció en más de un 50 por ciento el año pasado, un indicador

de que muchas de las plataformas tecnológicas más grandes del mundo continúan

infectadas de contenido ilegal.

Casi setenta millones

de imágenes y videos fueron reportados al Centro Nacional para Menores Desaparecidos y Explotados,

un centro de información para las imágenes de abuso infantil designado de

manera federal que trabaja con las agencias de seguridad pública.

La cifra récord fue

impulsada por un alza en los videos ilegales, que siempre han sido populares

entre los depredadores sexuales pero ahora son detectados con mayor facilidad

por algunas compañías. Más de 41 millones de videos fueron reportados; hace

cinco años el número era inferior a los 350.000. Las compañías marcaron muchas

de las mismas imágenes y videos en múltiples ocasiones a medida que fueron compartidos

entre usuarios.

El gráfico muestra que en 2019 la proporción de videos

de abuso reportados superó a las fotos.

.

El centro compartió con The New York

Times la identidad de las compañías que detectaron las imágenes; sería la

primera vez que se difunde información detallada de las empresas.

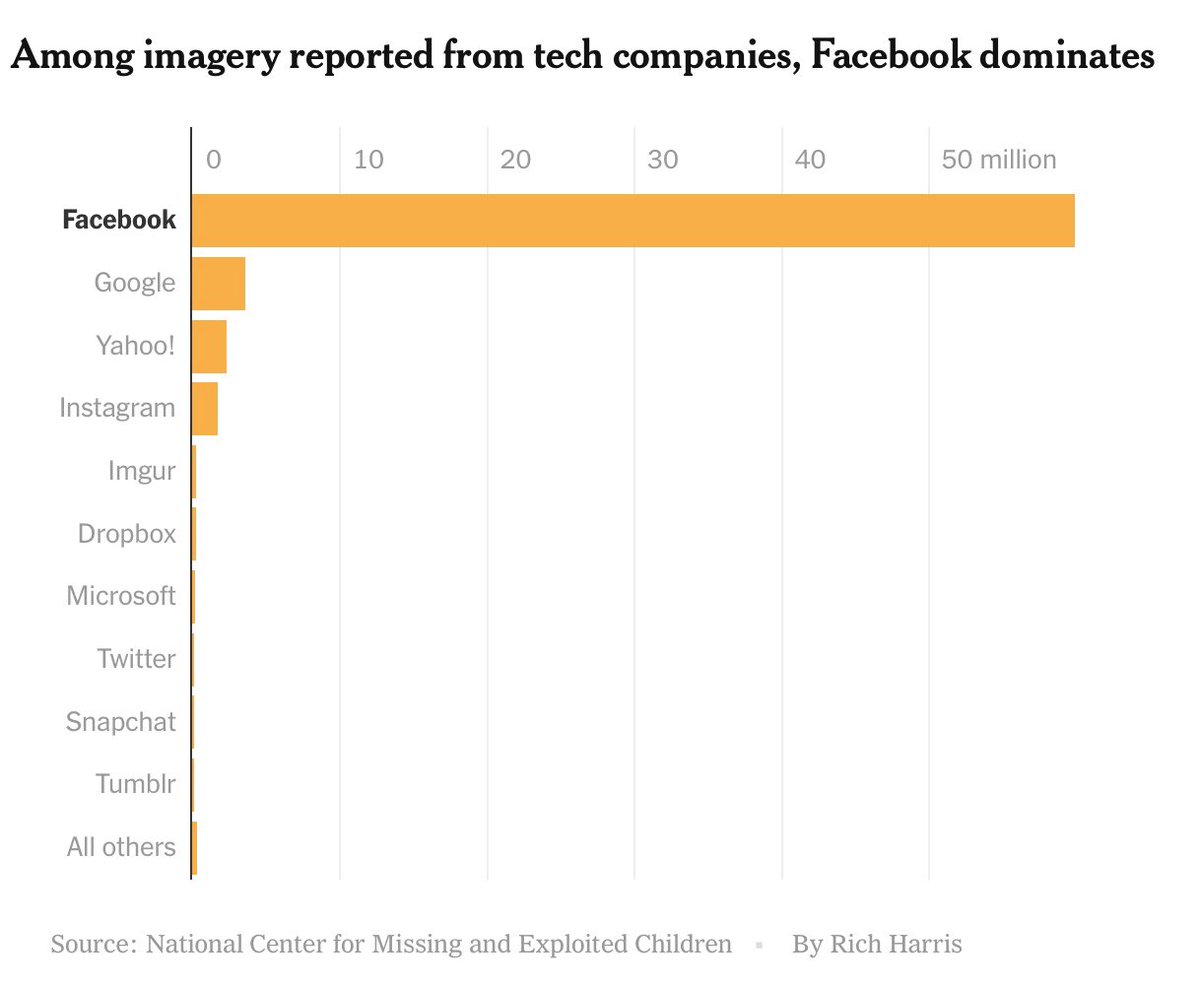

Facebook reportó casi sesenta

millones de fotografías y videos, más del 85 por ciento del total. El número

refleja tanto su inmensa base de usuarios como su enfoque agresivo para

eliminar el material, pero muestra que los delincuentes continúan explotando esa

plataforma. Casi la mitad del contenido no necesariamente era ilegal, de

acuerdo con la compañía, y fue reportado para ayudar a las instituciones de

seguridad pública con las investigaciones. Instagram, propiedad de Facebook,

fue responsable por 1,7 millones adicionales de fotografías y videos.

En un comunicado, Antigone Davis, la

responsable de seguridad global de Facebook, dijo: “El tamaño y la experiencia

de nuestro equipo, junto con nuestra tecnología sofisticada, nos han convertido

en líderes de la industria en detectar, eliminar y reportar estas imágenes, así

como en frustrar los intentos de compartirlas”.

“Continuaremos desarrollando las

mejores soluciones para mantener seguros a más niños”, agregó.

Snapchat, Twitter y otras compañías de redes sociales

también entregaron informes sobre imágenes. También lo hicieron empresas cuyos

servicios incluyen motores de búsqueda y almacenamiento en la nube, incluyendo

a Google y Microsoft. Apple, Dropbox y la plataforma de chat Discord también

detectaron el contenido ilegal.

En total,

164 compañías entregaron reportes.

“Estos números demuestran que

cualquier proveedor de servicios que permite a los individuos almacenar

imágenes y videos es susceptible a que se publique material de explotación

sexual infantil”, dijo John Shehan, un vicepresidente en el centro nacional.

Confirmó que los números divulgados

el 7 de febrero reflejaron todo el contenido reportado al centro, incluyendo

material que “podría no cumplir con la definición legal de pornografía

infantil”.

Sin embargo, los números no

representan una mirada completa al problema: la industria ha estado plagada de

prácticas de detección disparejas e inconsistentes, tal como informó el Times el año pasado. Algunos servicios de almacenamiento en

la nube, incluidos aquellos que son propiedad de Amazon y Microsoft, no

escanean nada en busca de contenido ilegal, mientras que otras compañías, como

Snap, escanean en busca de fotografías pero no de videos.

Los datos muestran amplias

disparidades en la industria tecnológica. Google reportó más de 3,5 millones de

imágenes y videos; Yahoo, más de 2 millones, e Imgur, un sitio para compartir

fotografías, más de 260.000. Dropbox, Microsoft, Snap y Twitter son las únicas

otras compañías que reportaron más de 100.000 imágenes y videos el año pasado.

Apple reportó una cantidad

dramáticamente menor de imágenes que la mayoría de los otros gigantes

tecnológicos, tan solo un poco más de tres mil, y ningún video. Estas cifras

reflejan la incapacidad de la compañía para escanear el material enviado a

través de su aplicación de mensajería, la cual está cifrada, así como el hecho

de que no escanea su servicio de almacenamiento de archivos, iCloud. Amazon,

cuyos servicios en la nube manejan millones de cargas y descargas cada segundo,

no envió imágenes o videos al centro nacional.

El senador Richard Blumenthal de

Connecticut, que ha promovido legislaciones de protección infantil y

recientemente fue parte de un grupo bipartidista de legisladores que

solicitaron a 36 compañías tecnológicas que detallaran sus

esfuerzos en esta área, calificó los números de “aterradores y alarmantes”.

“Los datos dispares reportados muestran que claramente

no podemos depender de que las compañías tecnológicas se autorregulen”, dijo.

Alex Stamos, quien fungió como

director de seguridad de información tanto en Facebook como en Yahoo, dijo que

los números eran un reflejo de las empresas que han puesto mayor esfuerzo en

encontrar y retirar el material de sus plataformas.

“Espero que estos números motiven a

la gente a hacer más, no menos”, dijo Stamos.

El gráfico siguiente muestra que entre las imágenes

denunciadas, Facebook es la empresa tecnológica dominante.

El año pasado, realmente hubo un

descenso en el número total de informes presentados al centro nacional, al

disminuir a 16,9 millones en comparación con los 18,4 millones de 2018. Eso

responde, en parte, a que las compañías tecnológicas mejoraron su proceso de

informes al agrupar fotografías y videos en vez de marcarlos de manera

individual.

Un informe individual usualmente

incluye múltiples fotografías y videos,- por ejemplo, cuando el material es

encontrado en la cuenta de correo electrónico de alguien—, así que el

crecimiento general en las imágenes reportadas podría señalar que “aquellos que

las están compartiendo, las comparten en grandes volúmenes”, dijo Shehan, del

centro nacional.

Algunas compañías que hicieron un

número pequeño de informes terminaron por encontrar un gran volumen de

imágenes. Por ejemplo, Dropbox realizó alrededor de cinco mil informes el año

pasado, pero descubrió más de 250.000 fotografías y videos. Para las víctimas

de abuso sexual infantil, la recirculación de las imágenes puede causar un

trauma.

Los delincuentes en línea son conocidos por buscar niños en las

fotografías y los videos, incluso en la edad adulta. Las víctimas, o los padres

de menores que sufrieron abuso, también reciben avisos legales cuando sus

imágenes son encontradas durante investigaciones, lo que se convierte en un

recuerdo constante de su dolor.

“Saber que estas imágenes están en línea y que otras

personas disfrutan con tu degradación como gratificación sexual de alguna

manera significa que siempre estás sufriendo abuso”, dijo Alicia Kozakiewicz,

una sobreviviente de abuso sexual infantil que desde hace tiempo se dedica a

educar sobre la seguridad en internet.

No obstante, el crecimiento de las

imágenes reportadas no brinda información sobre si más del contenido ilegal

está siendo producido nuevamente y publicado en línea. La mayoría de las

imágenes son detectadas por las compañías tecnológicas a través de escaneos

automatizados que solo reconocen material marcado de manera previa. Detectar

videos, los cuales el año pasado por primera vez superaron al número de

fotografías, es particularmente difícil porque la industria carece de un

estándar común para identificarlos.

Fuente: The New York Times.

Comentarios